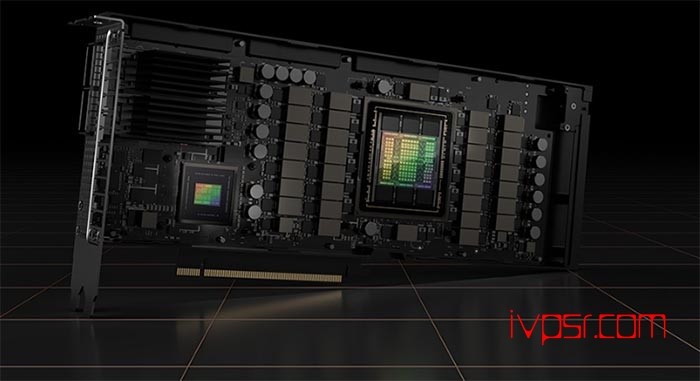

Oracle云采用Nvidia H100 GPU的计算

Oracle 云基础设施 (OCI) 已在 OCI 计算上普遍提供 Nvidia H100 Tensor Core GPU。H100 GPU 将作为 OCI Compute 裸机实例提供,面向大规模人工智能和高性能计算应用。研究发现,与 Nvidia 的 A100 GPU 相比,H100 可将 AI 推理性能提高约 30 倍,将 AI 训练提高四倍,但众所周知,它很难获得。

OCI 计算形状包括八个 H100 GPU,每个 GPU 具有 80GB HBM2 GPU 内存和 3.2Tbps 的对分带宽。该形状还包括 16 个本地 NVMe 驱动器,每个驱动器容量为 3.84TB,以及具有 112 个内核和 2TB 系统内存的第四代 Intel Xeon CPU 处理器。客户还可以使用 OCI Supercluster 来启动数以万计的 H100,以实现高性能网络。除了 H100 的发布外,基于 Ada Lovelace 架构的 Nvidia L40S GPU 也将于 2024 年初全面上市。该芯片是一款适用于数据中心的通用 GPU,专为大型语言模型 (LLM) 推理和训练、视觉计算和视频应用而设计。这些实例将为中小型 AI 项目以及图形和视频计算任务提供 H100 和 A100 实例的替代方案。

与 A100 相比,L40S 可以将生成式 AI 工作负载的性能提高 20%,并将微调 AI 模型的性能提高 70%。OCI 并不是唯一一家部署 H100 的公司。8 月,Google宣布推出新的 A3 虚拟机,同样配备 H100 GPU 和第四代 Xeon 可扩展处理器,可扩展至 26,000 个 H100,AWS于 7 月开始提供 GPU,作为其 EC2 P5 实例的一部分。

由于人工智能需求,英伟达的估值飙升至1 万亿美元以上,但 GPU 也严重短缺。由于短缺,Nvidia 向 CoreWeave 和 Lamda Labs 等小型云公司提供了优先访问权。该芯片制造商已投资前者,并正在洽谈投资后者。